Удаленный сервер для аналитики данных: как выбрать

Содержание:

- Как оценить требования к железу для аналитики данных на удаленном сервере

- Что учитывать при выборе облачного провайдера для аналитических задач

- Удаленный сервер для аналитики данных от ZSC – мощная среда для принятия точных решений

- Как настроить и оптимизировать удаленный сервер для обработки больших данных

Не менее важным моментом является производительность системы. При анализе сложных или многомерных объектов важна не только скорость обработки запросов, но и способность платформы масштабироваться по мере роста задач. Это особенно актуально для бизнесов, где информационные потоки постоянно увеличиваются. Отказ от собственного оборудования в пользу виртуальных решений дает возможность гибко адаптировать ресурсы под изменяющиеся потребности.

Сетевые возможности и надежность в передаче информации также играют ключевую роль. Чем быстрее и стабильнее будет обмен между компонентами, тем выше производительность всей системы. Нельзя забывать и о безопасности: доступ к конфиденциальным данным должен быть защищен от несанкционированных вторжений, что требует применения соответствующих технологий шифрования и аутентификации.

Важнейшим моментом является интеграция. Не все облачные решения одинаково хорошо поддерживают специфические инструменты и ПО, необходимые для анализа. Выбор провайдера должен учитывать не только наличие необходимых функций, но и простоту подключения существующих сервисов для максимально удобной работы команды.

Как оценить требования к железу для аналитики данных на удаленном сервере

При подборе аппаратного обеспечения для обработки больших объемов информации, нужно учитывать несколько факторов. Важно точно рассчитать, какие ресурсы потребуются для работы с вашими запросами и нагрузками.

Процесс начинается с определения объема информации, которую предстоит обрабатывать. Для этого следует обратить внимание на следующие параметры:

- Процессор (CPU):рекомендуется выбирать многоядерные процессоры с высокой тактовой частотой, которые обеспечат эффективную многозадачность при обработке данных. Для интенсивных вычислений подходят модели с 8 и более ядрами.

- Оперативная память (RAM): количество памяти влияет на скорость обработки и хранение промежуточных данных. Для обработки больших наборов данных потребуется от 32 ГБ до 256 ГБ в зависимости от сложности задач.

- Хранение (SSD): для работы с большими объемами данных предпочтительнее использовать твердотельные накопители (SSD), которые значительно ускоряют процесс чтения и записи по сравнению с жесткими дисками. Размер хранилища зависит от объема данных, но минимально стоит рассчитывать на 1-2 ТБ.

Следующий этап – оценка характера выполняемых задач. Если предполагаются операции с большими объемами данных или сложные вычисления, такие как машинное обучение или анализ больших таблиц, необходимы дополнительные компоненты.

Что учитывать при выборе облачного провайдера для аналитических задач

При выборе платформы необходимо учитывать мощность вычислений. Она должна быть достаточной для обработки интенсивных вычислений и работы с большими объемами информации. Убедитесь, что провайдер предлагает нужные типы машин, включая поддержку графических процессоров, если планируется использовать алгоритмы машинного обучения или обработку изображений.

Необходимо оценить уровень безопасности платформы. Платформа должна включать механизмы защиты данных, такие как шифрование в процессе передачи и хранения, а также эффективное управление доступом. Проверьте наличие сертификатов безопасности, таких как ISO 27001, и соблюдение стандартов защиты личной информации.

Гибкость масштабирования – еще один важный критерий. Убедитесь, что провайдер позволяет быстро увеличивать ресурсы по мере необходимости. Некоторые платформы предлагают автоматическое масштабирование, что позволяет оптимизировать затраты и поддерживать стабильную работу при изменении объема задач.

Интеграционные возможности также не стоит игнорировать. Проверьте, поддерживает ли платформа интеграцию с нужными внешними сервисами, такими как базы данных, BI-инструменты или платформы для машинного обучения.

Удаленный сервер для аналитики данных от ZSC – мощная среда для принятия точных решений

Компания ZSC предоставляет в аренду надежные и высокопроизводительные удаленные серверы, оптимизированные под задачи аналитики и обработки данных. Это профессиональное решение для специалистов в области BI, Big Data, Data Science и автоматизации отчетности.

Мы разворачиваем серверы в российских или зарубежных дата-центрах с учетом ваших требований – будь то работа с PostgreSQL, ClickHouse, Python, R, Jupyter, Power BI, Metabase или платформами для машинного обучения. Серверы масштабируются под объемы данных и позволяют обрабатывать большие массивы информации в реальном времени – быстро, стабильно и безопасно.

Команда ZSC выполняет полную настройку окружения под ключ: установка нужных инструментов, перенос существующих данных и скриптов, настройка защищенного VPN-доступа, организация резервного копирования и круглосуточная техническая поддержка. При необходимости реализуем кнопку экстренного отключения сервера – для критических сценариев безопасности.

С удаленным сервером от ZSC вы получаете гибкую платформу для аналитики, которая всегда под рукой, готова к работе 24/7 и полностью контролируема. Это идеальное решение как для внутренних аналитических подразделений, так и для внешних консалтинговых команд.

Оставьте заявку – и мы подготовим серверную инфраструктуру, на которой ваша аналитика будет работать быстро, точно и безопасно.

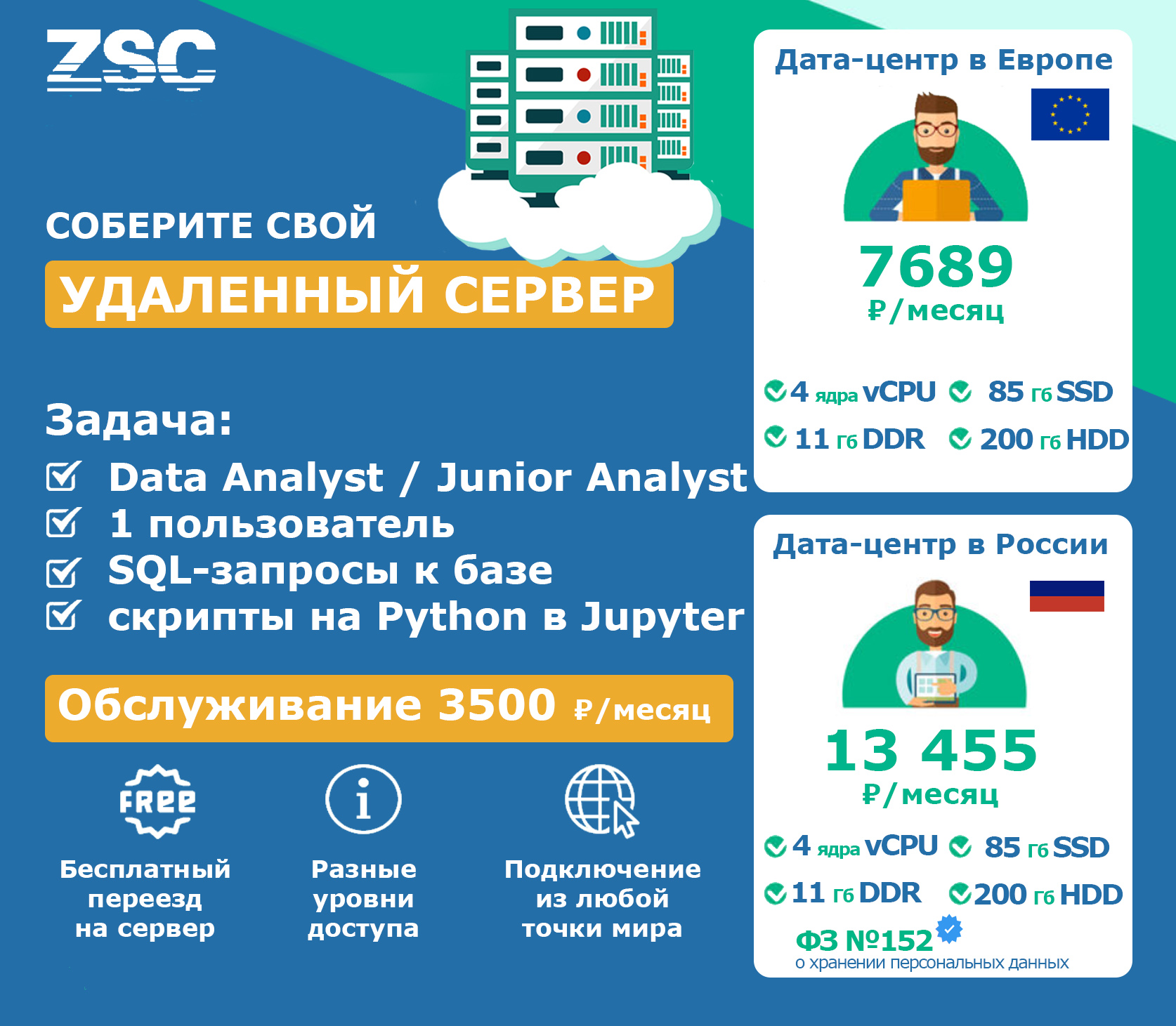

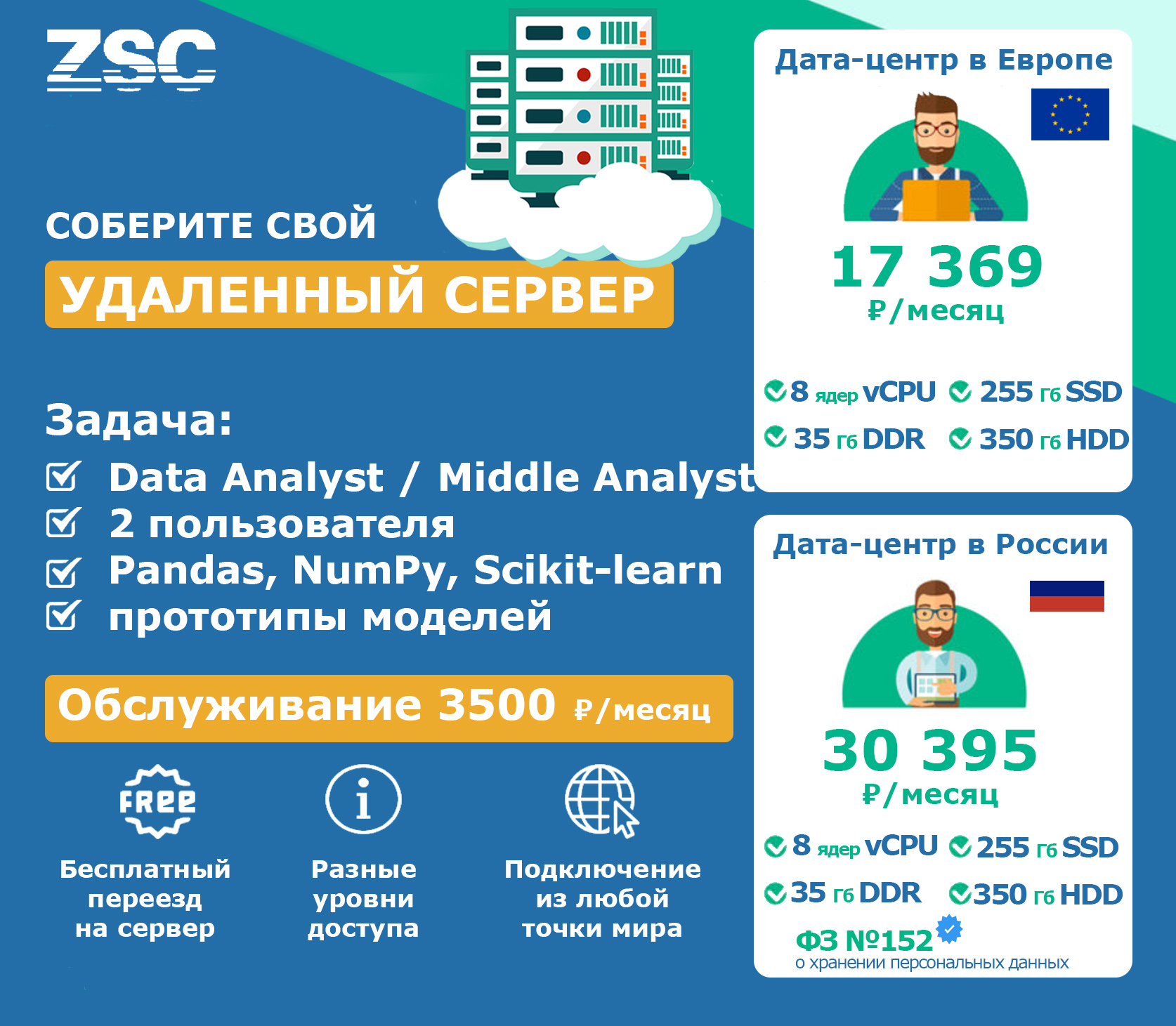

Мы приготовили для вас готовые конфигурации удаленного сервера:

Воспользуйтесь нашим калькулятором и соберите свой удаленный сервер

Как настроить и оптимизировать удаленный сервер для обработки больших данных

Для работы с массивами информации, требующими значительных вычислительных мощностей, необходимо правильно подобрать параметры хостинга и настроить систему для обеспечения максимальной производительности. Важно помнить, что эффективность обработки зависит от множества факторов, начиная от архитектуры оборудования и заканчивая выбором соответствующего ПО.

Перед установкой следует выбрать подходящий тип ресурсов. При обработке объемных массивов данных важно опираться на серверы с многоядерными процессорами и большим объемом оперативной памяти. Если задача предполагает работу с большими базами или расчетами, потребуются мощные процессоры и система хранения данных с высокой пропускной способностью.

Одной из ключевых задач является настройка балансировки нагрузки. Это поможет равномерно распределить запросы между различными узлами и минимизировать задержки. Для этого используют технологии виртуализации и контейнеризации, например, Docker, который позволяет изолировать приложения и обеспечивать их работу в разных средах без ущерба для производительности.

Параллельная обработка – еще один важный аспект. Для повышения скорости работы необходимо настроить системы, поддерживающие многозадачность, такие как Apache Spark или Hadoop. Эти платформы позволяют эффективно распределять задачи между несколькими вычислительными узлами, сокращая время обработки больших объемов информации.

При выборе базы данных стоит ориентироваться на решение, которое поддерживает масштабируемость и может справляться с высокими нагрузками. PostgreSQL и MySQL с настройками репликации и кластеризации обеспечат устойчивую работу при росте объема информации.

Для ускорения обработки запросов рекомендуется использовать кеширование. Например, Redis позволяет сохранять промежуточные результаты вычислений, что значительно ускоряет повторные запросы к тем же данным. Кеширование снизит нагрузку на хранилище и ускорит доступ к данным, тем самым сокращая время отклика системы.

Не менее важным аспектом является настройка мониторинга. Инструменты вроде Prometheus и Grafana позволяют отслеживать загрузку ресурсов, производительность и выявлять потенциальные проблемы на ранней стадии. Мониторинг помогает оперативно реагировать на сбои в работе системы и поддерживать стабильность работы с массивами информации.

Наконец, регулярные обновления и поддержка безопасности критичны для долгосрочной работы системы. Обновления должны включать как патчи для уязвимостей, так и оптимизацию ПО для повышения производительности. Это позволит уменьшить риски и гарантировать эффективность системы в условиях постоянно увеличивающегося объема данных.

Читайте также:

- Удаленный сервер для работы с SCAD Office

- Удаленный сервер для работы с DIALux evo

- Выбор удаленного сервера для нужд разработчика

- Удаленный сервер для аналитики и BI-задач